從學貓看世界到 AI 看懂世界:電腦視覺簡史

手機的臉部辨識做身份認證、寶寶攝影機遠端偵測異常趴睡姿勢,即時通知父母、進出停車場的車牌辨識自動收費,電腦視覺科技在我們的生活中無所不在。

在上一期的電子報〈DeepSeek 衝擊 AI 產業:傑文斯悖論如何重塑市場競爭?〉刊出後,收到許多回饋,其中不少希望可以更了解深度學習技術在電腦視覺領域的發展歷史。因此這篇文章就要來聊聊影像識別一路以來的技術發展,以及技術採用的關鍵資源是如何影響商業市場,讓電腦視覺科技融入到我們的日常生活當中。

那就開始吧!

電腦視覺,從學貓看世界開始

電腦視覺的歷史始於 1960 年代初期,從生物學家研究生物的視覺機制所啟發。

D. H. Hubel 與 T. N. Wiesel 在 1959 年發表的經典論文〈Receptive fields of single neurones in the cat’s striate cortex〉中,探討了靈長類動物和哺乳類動物的視覺處理是如何進行的。他們把一些電極黏到貓腦後部的視覺皮層區域,並在貓的眼前反覆投影點狀、條紋,以及有邊緣的圖形,並微調光線的方向、移動速度、亮暗對比等參數,然後觀察什麼刺激會讓這些神經元有反應。

Hubel 與 Wiesel 在實驗中發現,視覺皮層中存在兩種對視覺刺激呈現不同敏感度與反應方式的神經元:簡單細胞與複雜細胞。

簡單細胞擅長於偵測視野中特定位置的方向或邊緣,而複雜細胞則是對圖形的移動反應更敏感。研究者推測,複雜細胞或許透過整合多個簡單細胞的輸入,而形成更高層次的視覺處理能力,能捕捉動態變化,進一步展現了視覺皮層由低階到高階的層級式訊息加工模式。

40年之後,科學家在思考如何讓電腦產生跟人類一樣的視覺能力時,也參考利用不同的細胞進行分工,最終再進行特徵分析與整合的模式。1959 年的生物學研究,在無意間對電腦視覺神經網路模型架構設計產生深遠的影響。

機器學習演算法的瓶頸

2000年代以前,電腦視覺的科學家也提出了將視覺世界簡化為簡單的幾何形狀,然後將表面、深度資訊、層次或視覺場景的不連續性拼湊在一起,並根據表面和體積等按層次結構組織 3D 模型的想法。但是受限於可使用的資料非常少,電腦的速度也很慢,技術上遲遲沒有重大突破。

1999 年開始,統計機器學習技術開始發展,包括支援向量機(Support Vector Machine)、提升法(Boosting)、圖形模型(Graphical Models),包括第一波神經網路(Neural Networks)。2001 年由 Paul Viola 和 Michael Jones 使用 AdaBoost 演算法進行即時人臉偵測。當時電腦的運算速度還非常慢,但它能夠幾乎即時地在圖像中進行人臉檢測,並且在這篇論文發表五年後的 2006 年,富士膠片推出了第一台配有即時人臉檢測器的數位相機,顯示從基礎科學研究到實際應用快速的轉換落地。

雖然有突破,但大多數機器學習演算法也有缺點:很容易在訓練過程中過度擬合(Overfitting)。也就是,假設有一個專門用來辨識「貓」或「狗」照片的模型,並準備了一批訓練資料供它學習。若這些貓的照片大多出現在室內,且背景顏色偏暖色調;而狗的照片則大多出現在戶外、背景顏色偏冷色調,模型在學習過程中可能誤以為背景的色調才是用來區分貓與狗的關鍵特徵。這樣的情況下,模型雖然能在訓練資料上得到極高的準確度,但一旦遇到全新、背景顏色和訓練集不同的貓或狗照片,模型就會大幅失準。

這種只「記住」訓練資料中一些無關或偶然特徵,而非真正能區分貓與狗的通用特徵,便是過度擬合的典型表現。模型在訓練資料上看似表現完美,但真正投入實際應用時,往往會出現高錯誤率,只要是模型在訓練階段沒有見過的圖片,他就認不得了。

如果要識別世界上的每一個物體或大多數物體,除了要解決過度擬合的問題以外,還要有足夠的圖片資料幫助模型訓練。

劃世代的新架構 —— 卷積神經網路(CNN)登場

2000 年左右消費型數位相機開始普及,並開始取代傳統的底片相機;十年後,智慧型手機內建的相機功能再次取代了輕便型數位相機市場。網路上大量、高解析度的圖片為這個時代奠定基調。

2006 年,李飛飛帶領研究團隊開始了 ImageNet 計畫,花了三年的時間從網路上收集全世界大量的圖片進行整理與標記,最終 ImageNet 標記了近 1400 萬幅圖像,按照 2200 萬個物體和場景進行分類, 這是當時人工智慧領域所收集到最大的圖片資料集 。

為什麼要收集這麼多圖片?除了提供模型訓練使用以外,當時研究學者也需要一個共同的評價基準(Benchmark),用來判斷哪些模型表現比較好。

既然可以當作模型評價指標,那辦個比武大賽也很合理吧?

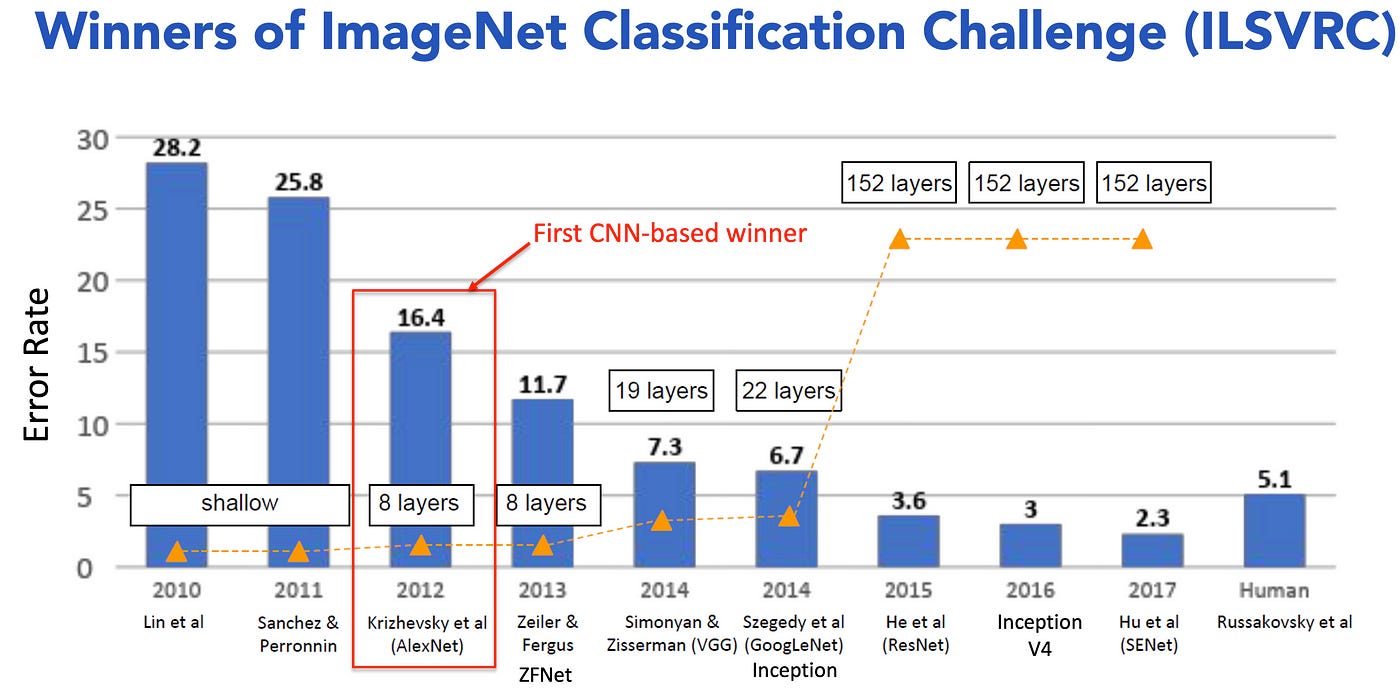

2010 年開始,ImageNet 團隊推出了一項名為 ImageNet 大規模視覺識別挑戰賽的國際挑戰賽(ILSVRC),參賽團隊要用自己開發的模型對 140 萬張圖片辨識出 1000 種物體類別。模型可以對每張圖猜五個答案,只要這五個裡面有包含到正確答案,則視為辨識成功。最終再以模型的錯誤率做排名。

2012年,Alex Krizhevsky 等人用 AlexNet 模型以極大的領先幅度打敗對手,贏下冠軍。相較於先前冠軍團隊都是採用機器學習模型,AlexNet 採用深層卷積神經網路架構(Convolutional Neural Network, CNN),再搭配一些模型訓練技巧,克服過度擬合的問題。此外,為了加速模型訓練,團隊在兩張消費級高階顯示卡 NVIDIA GTX 580 上進行平行運算,這種做法令人驚豔,因為當時多數影像辨識依賴 CPU 或單張 GPU。

AlexNet 在 2012 年 ImageNet 競賽的勝利,對整個深度學習領域產生了突破性的影響,也間接提升了 NVIDIA 在高效能運算與人工智慧市場的地位,讓更多研究機構和產業界開始採用 GPU 來取代 CPU 或其他硬體進行深度學習,NVIDIA 逐漸成為「AI 加速」的代名詞。隨著市場對 GPU 的需求暴增,NVIDIA 也開始投入更多資源開發針對深度學習優化的 GPU 與軟體開發套件(如 CUDA、cuDNN 等),並積極拓展雲端運算、資料中心與自動駕駛等領域的合作機會。

AlexNet 開啟深度學習於電腦視覺的黃金時代,也引領後續更多大型神經網路架構發展。

深度學習時代的爆發

在 AlexNet 發表之後,研究者與企業界在 CNN 架構基礎上展開多元的探索與創新。像是把 CNN 神經網路的層數加深以提高準確度、架構設計中加入不同尺度特徵的辨識模組,或是從單純影像分類擴展到更複雜的視覺任務,像是理解更細緻的場景資訊。

後續注意力機制(Attention)與 Transformer 架構在影像領域崛起,能聚焦關鍵區域並提升整體辨識效率。其中 Google 推出的 Vision Transformer(ViT)將影像切割成多個區塊,再透過自注意力建模區塊間關聯,強化全局視野。

研究者與企業開始大量運用雲端伺服器進行大規模資料訓練與推論。自 2012 以降,較知名的 CNN 模型架構如 GoogLeNet(2014)、微軟研究院的 ResNet(2015) 或是 Transformer 架構的 ViT(2020),都是使用自家資料中心雲端的高階 GPU 或是 TPU 等大規模運算資源進行模型訓練。

這些 AI 技術突破,也反映在全球 IT 產業在資料中心系統的支出數字上。大型科技公司自 2000 年開始持續擴建資料中心,除了 2009 年受到金融海嘯與 2020 年受到疫情影響,使支出數字衰退,其他年都是持續成長。而且在近 25 年間,數字已經翻了四倍。

這反應了隨著人工智慧應用普及、企業數位轉型加速,加上串流影音、遊戲等消費服務的興起,對運算資源和儲存空間的需求呈現爆炸性成長。

但這樣的集中式模式需要穩定且高速的網路傳輸,也衍生頻寬成本與即時性限制。隨著物聯網(IoT)快速普及邊緣端的應用需求逐漸增加,推動技術由雲落地。

從雲端落地,走入日常

邊緣運算(Edge Computing)指的是在資料產生或收集的「邊緣」端,就地進行資料處理與分析,而非將所有資料都傳送到遠端資料中心或雲端再進行運算。

想像一下:你在一台自動駕駛的車上,路邊突然有一隻狗衝出來,此時的你應該不會希望等待感測器把資料傳到雲端,雲端算完得到一個「踩煞車」的指令,再回傳到車上的控制系統吧?太慢了!狗已經被輾過去了。

因此藉由將運算能力下放到邊緣,就可以在現場快速進行決策或執行動作,降低延遲並節省頻寬。這樣的作法在許多應用中尤其重要,包含智慧城市、工業自動化、自動駕駛以及醫療監護等,因為這些場景需要即時且穩定的反應,等不及長時間的雲端回傳。另一方面,邊緣運算也能有效保護隱私與敏感資料,因為資料僅在本地端處理,不必大規模外流或儲存在雲端。

邊緣運算受益於多重因素疊加才能實現。大約在 2015 年左右,隨著行動裝置與物聯網應用的快速普及,市場對即時運算與資料隱私的需求日益提升,進一步推動將演算法下放到終端執行。硬體廠商陸續推出行動 GPU、NPU 及微型化加速器,同時深度學習社群也開發出輕量化模型(如 MobileNet、SqueezeNet 等),讓模型在有限的運算資源下,依然有出色的性能表現。

此外,企業與研究機構也嗅到商機,開始投入研發能在邊緣端完成即時決策的解決方案,智慧攝影機、工業自動化、車載系統等場景由此受益。透過硬體演進、演算法優化與產業推動多方合力,邊緣運算終於從理論走向落地實踐。

結語

從電腦視覺的發展歷程中不難發現,要讓一項新技術真正落地,需要研究者、產業界、硬體廠商、以及使用者等多方協同努力。

早在 1998 年就已有人提出 CNN 模型架構,但直到 2012 年 GPU 加速運算普及後,深度學習才得以快速竄起。2000 年以前,許多影像辨識相關的理論雖然在學術界已逐漸成形,卻苦於缺乏夠大的影像資料集與運算資源,難以進行大規模驗證。但是隨著數位相機與智慧型手機的盛行,全球影像與影片量呈指數成長,成為龐大且不斷更新的訓練池。再加上 GPU、TPU 等硬體迅速升級,逐步打破算力限制,讓過去只能存在論文中的技術有了大規模實踐的機會。

也因為了解這些歷程,才能體會如今我們能夠享受自動駕駛、手機臉部解鎖,或是寶寶攝影機的便利,是件很幸福的事。